2 x pro Woche

Abonnieren Sie unseren Newsletter.

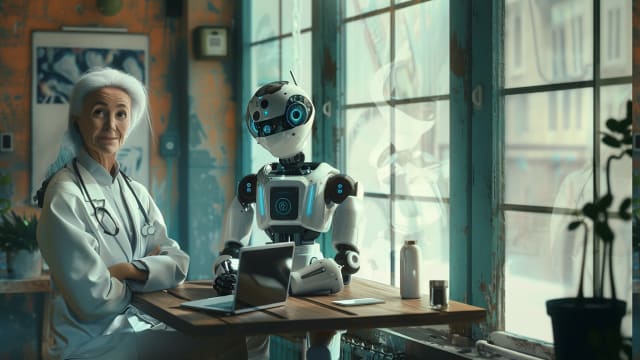

Für die Zweitmeinung zu Dr. KI? Kein Problem.

Die meisten Menschen können sich vorstellen, medizinischen Rat bei einem Chatbot zu holen. Und eine klare Mehrheit findet, dass die Ärzte KI-Unterstützung haben sollten. Dies besagt eine Erhebung in Deutschland.

, 19. August 2024 um 22:07letzte Aktualisierung: 22. November 2024 um 08:03

Keine Angst – aber bitte Kontrolle

- Moritz Reis, Florian Reis, Wilfried Kunde: «Influence of believed AI involvement on the perception of digital medical advice», in: «Nature Medicine», Juli 2024.

- doi: 10.1038/s41591-024-03180-7

«Vernachlässigung der Einzigartigkeit»

- Die Leute glauben Dr. Google. Aber Dr. KI trauen Sie nicht über den Weg. Greifen Ärzte auf Künstliche Intelligenz zurück, so stösst dies bei den Patienten auf Widerstand.

- KI-Chatbots wären miserable Ärzte: Sie stellen vorschnelle Diagnosen, scheren sich nicht um Richtlinien und verlangen riskante Untersuchungen.

Artikel teilen

Kommentar

Heimarzt-Besuche: Krankenkassen kritisieren Weg- und Wechsel-Entschädigungen

Das SRF-Konsumentenmagazin «Kassensturz» prangert hohe Wegentschädigungen von Heimarztbesuchen an. Die betroffene Firma Emeda verteidigt ihr Abrechnungsmodell, hat aber Anpassungen vorgenommen.

Nachfolge gesucht: MPA-Team schreibt Arztstelle aus

In Münsingen läuft es für einmal umgekehrt: Medizinische Praxisassistentinnen suchen Ärzte – um gemeinsam eine Praxis weiterzuführen.

Medbase expandiert in der Westschweiz

In Bulle plant die Praxis-Gruppe ein neues medizinisches Zentrum.

Pallas Kliniken streichen 20 Stellen

Das Familienunternehmen will sich am Hauptsitz in Olten auf weniger Fachbereiche fokussieren.

2025 im Zeichen der KI: Drei wichtige Trends für das Gesundheitswesen

Der Wissenschaftsverlag Wolters Kluwer hat herausgearbeitet, wo Künstliche Intelligenz die Medizin in nächster Zeit speziell prägen könnte. Schwerpunkte liegen auf smarter Ausbildung und auf der Patientensicherheit.

Gemeinsam erfolgreich: Medinside wächst um über 70 Prozent

In eigener Sache: Medinside erlebte 2024 als Jahr des Wachstums und Erfolgs. Mit Ihrer Unterstützung bauten wir unsere Position als führende Plattform für Gesundheitsprofis weiter aus.

Vom gleichen Autor

USZ: Mehr Vertrauen in die Spitalleitung

Die Fluktuationsrate des Personals im Universitätsspital Zürich erreichte letztes Jahr 13 Prozent. Im Kantonsspital Winterthur lag sie bei 11 Prozent.

Kantonsspital Winterthur kämpft sich zurück

Mehr Patienten, strikteres Kostenmanagement, verbesserte Abläufe: Das KSW konnte letztes Jahr den Verlust halbieren.

Zurück auf die Beine: Stimulation hilft Gelähmten beim Gehen

Ein neues Verfahren aus Lausanne verbindet Rückenmark-Stimulation mit Robotik – um bei Querschnittgelähmten die Muskelkoordination zu verbessern. Das System könnte weltweit in Reha-Kliniken eingesetzt werden.